Differenza tra Fine Tuning e RAG per l’addestramento delle AI.

La capacità di un modello di Intelligenza Artificiale è determinata dal suo addestramento. Il tipo di addestramento determina la capacità della AI di comprendere la domanda e la conseguenze efficacia della risposta.

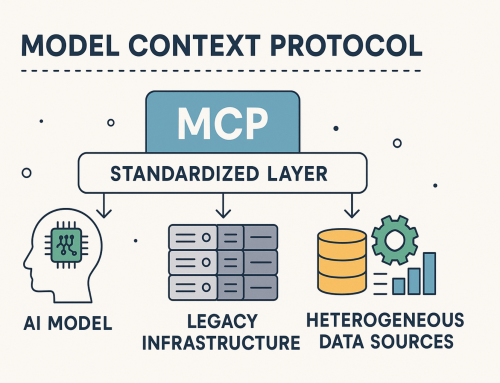

A partire dallo specifico LLM (Large Language Model – ne abbiamo parlato qui) possiamo avere due diverse possibilità di migliorare le prestazioni di una AI (generativa): il Fine Tuningn (qui) e il RAG (qui).

Capire le differenze tra Fine Tuning e RAG

La differenza tra “fine tuning” e “RAG (Retrieval Augmented Generation)” riguarda due aspetti diversi dell’addestramento e del funzionamento dei modelli di intelligenza artificiale.

Fine Tuning: Questo processo si riferisce all’adattamento di un modello di intelligenza artificiale già pre-addestrato a un compito specifico o a un set di dati particolare. In pratica, il modello, che è stato addestrato su un vasto e generico dataset, viene ulteriormente addestrato (o “affinato”) su un dataset più piccolo e specifico. Questo consente al modello di specializzarsi meglio su quel compito o su quel tipo di dati. Il fine tuning è spesso utilizzato per migliorare le prestazioni di un modello in specifici ambiti o per adattarlo a linguaggi, stili o formati particolari.

RAG (Retrieval Augmented Generation): Questo è un approccio nell’ambito dell’intelligenza artificiale, in particolare nei modelli generativi, che combina la generazione di risposte con un meccanismo di ricerca di informazioni. In pratica, quando il modello deve generare una risposta, prima esegue una ricerca nelle sue fonti di dati (come documenti, pagine web, ecc.) per trovare informazioni pertinenti. Poi, utilizza queste informazioni recuperate per informare o arricchire la risposta generata. Questo approccio è particolarmente utile per aumentare l’accuratezza e la pertinenza delle risposte in contesti dove sono necessarie informazioni specifiche o aggiornate.

In sintesi, mentre il fine tuning è un metodo per specializzare un modello pre-addestrato a compiti specifici, RAG è una tecnica che consente ai modelli di generazione di arricchire le proprie risposte attingendo da fonti esterne di informazioni.

Nei modelli RAG è fondamentale il tipo di prompt.

Entrando nel dettaglio. Quando si utilizza un sistema RAG il prompt, ovvero la conversazione che si tiene con le AI è fondamentale. È il prompt a fornire alle AI il contesto in cui elaborare le risposte.

Nel RAG, la natura del prompt determina:

- Quali informazioni vengono ricercate. Il modello utilizza il prompt per comprendere il contesto e la specifica richiesta di informazione. Questo processo guida la ricerca nelle fonti di dati esterne, permettendo di recuperare informazioni pertinenti.

- Il tipo di risposta generata dal modello RAG, che sarà direttamente influenzata dal prompt, integrando le informazioni recuperate durante il processo di ricerca nella risposta, e rendendola più informata e pertinente al contesto del prompt.

- L’accuratezza e la pertinenza della risposta, ovvero è il prompt ad indicare alla AI come effettuare la ricerca perché sia mirata e di conseguenza di generare una risposta più accurata e rilevante.

Nel RAG, il prompt non è solo il punto di partenza per la generazione di una risposta, ma è anche un elemento critico che guida l’intero processo di ricerca e generazione, influenzando significativamente la qualità e la pertinenza della risposta finale.

Nei modelli Fine Tuning è fondamentale il dataset.

In questo processo, il contesto e la capacità del modello di generare risposte accurate derivano principalmente dal dataset specifico utilizzato nell’addestramento. Il modello impara da questi dati specializzati e diventa più abile nel rispondere a domande o compiti che sono strettamente correlati a quel contesto. In altre parole, il fine tuning affina le competenze del modello in base ai dati di addestramento, rendendolo più efficace in un determinato dominio o tipo di compito. Naturalmente i dati utilizzati nel Fine Tuned devono essere di altissima qualità, e non devono essere coerenti con il tipo di addestramento, ma soprattutto di risposte attese dall’addestramento.

Fine Tuning o RAG: quale scegliere

La scelta di un modello o di un altro, dipende principalmente dall’uso previsto del sistema di intelligenza artificiale, dalle esigenze degli utenti, dalla natura delle interazioni previste, dalla necessità di accesso a informazioni esterne, dalla competenza degli utenti nel formulare domande, e dall’ambiente specifico di utilizzo del sistema AI.

Considerando alcuni fattori chiave:

- Velocità e Fluenza della Conversazione: Se l’obiettivo è avere una conversazione rapida e fluida con risposte immediate, il fine tuning potrebbe essere più appropriato. I modelli fine-tuned possono rispondere rapidamente e in modo coerente in base al loro addestramento specifico, senza dover cercare attivamente informazioni esterne. Questo li rende ideali per applicazioni che richiedono interazioni veloci e senza interruzioni, come i chatbot per il servizio clienti o le applicazioni di assistenza vocale.

- Profondità e Specificità delle Informazioni: Se la richiesta è per risposte più dettagliate, aggiornate o in settori molto specifici, il RAG può essere più adatto. Questo approccio è particolarmente utile quando le risposte richiedono la consultazione di informazioni esterne o recenti, come dati di ricerca o notizie aggiornate. Il RAG è più adatto per utenti che necessitano di informazioni precise e hanno il tempo di formulare prompt chiari e specifici.

- Competenza degli Utenti: Come hai menzionato, la competenza degli utenti nel formulare i prompt gioca un ruolo importante. Gli utenti che sono in grado di formulare domande chiare e specifiche trarranno maggiori benefici dal RAG, poiché ciò aiuterà il sistema a recuperare informazioni più pertinenti. Al contrario, per gli utenti che preferiscono interazioni più casuali o non sono abituati a formulare prompt dettagliati, un modello fine-tuned potrebbe essere più accessibile.

- Ambito di Applicazione: Alcuni contesti specifici possono trarre maggiori benefici dall’uno o dall’altro approccio. Ad esempio, il fine tuning è ideale per applicazioni dove è richiesta una grande coerenza con un certo stile o linguaggio (come un assistente virtuale di marca), mentre il RAG è utile in scenari che richiedono l’accesso a un’ampia gamma di informazioni aggiornate o di nicchia.

Le differenza di LM da utilizzare

Il funzionamento di una qualsiasi AI dipende dal LM (Language Model) utilizzato, ovvero alla sua ampiezza. Maggiore è l’ampiezza del LM, come adempio un LLM (Large Language Model) come quello di ChatGPT, maggiore è l’efficacia della risposta. Ma maggiori sono le necessità in termini di hardware e di consumi energetici, ovvero di risorse economiche.

Ora, la relazione tra la dimensione del Language Model (LM) e l’approccio usato, sia esso fine tuning o RAG (Retrieval Augmented Generation), non è necessariamente diretta, ma ci sono alcune considerazioni generali da tenere in mente:

- Fine Tuning: Il fine tuning può essere applicato a modelli di qualsiasi dimensione. L’idea di base è che un modello pre-addestrato, sia esso grande o piccolo, viene ulteriormente addestrato su un set di dati specifico per migliorare le sue prestazioni in quell’ambito particolare. Modelli più grandi possono già avere una conoscenza generale più ampia e una maggiore capacità di apprendimento, il che potrebbe tradursi in prestazioni migliori dopo il fine tuning. Tuttavia, anche modelli più piccoli possono beneficiare significativamente del fine tuning, soprattutto se l’ambito di applicazione è molto specifico.

- RAG: L’approccio RAG è generalmente più complesso e può beneficiare di modelli di linguaggio più grandi. Ciò è dovuto al fatto che il RAG non si limita a generare risposte basate sulla sua formazione, ma integra anche la capacità di ricercare e utilizzare informazioni esterne. Un modello più grande ha spesso una migliore comprensione del linguaggio e della semantica, che può aiutare a interpretare meglio il prompt dell’utente e a integrare in modo più efficace le informazioni recuperate.

In sintesi, mentre i modelli più grandi possono offrire vantaggi sia nel fine tuning che nel RAG per via della loro conoscenza generale più ampia e delle capacità di comprensione del linguaggio, l’uso di un modello più piccolo o più grande dipende dall’obiettivo specifico e dalle risorse disponibili. Per il fine tuning, un modello più piccolo può essere sufficiente e più gestibile, specialmente per scopi molto specifici. Per il RAG, un modello più grande potrebbe essere preferibile per sfruttare al meglio la sua capacità di integrare e utilizzare le informazioni provenienti da fonti esterne.

Quando usare il Fine Tuning e quando usare RAG

Partiamo da Fine Tuning. La scelta tra fine tuning e l’ampiezza del Language Model (LM) può dipendere significativamente dall’argomento e dalla specificità del dataset. Quando si tratta di argomenti molto verticali o di nicchia, con regole chiare e un ambito ben definito, un fine tuning su un LM di dimensioni minori può essere effettivamente sufficiente e persino vantaggioso, e questo per una serie di motivi:

- Efficienza in Argomenti Specializzati: In contesti altamente specializzati, il corpus di conoscenze rilevanti è spesso più ristretto e meno variabile. Un modello più piccolo, fine-tuned su un dataset specifico, può imparare efficacemente queste conoscenze senza la necessità di gestire l’ampia gamma di informazioni che un modello più grande deve affrontare.

- Velocità e Risorse: Modelli più piccoli richiedono generalmente meno risorse computazionali e di memoria. Questo li rende più veloci da addestrare e da eseguire, il che è un vantaggio significativo in applicazioni pratiche, soprattutto quando si richiedono risposte rapide.

- Minore Rischio di Overfitting: In contesti molto specifici, un modello più grande può a volte soffrire di overfitting, ovvero diventare troppo adattato al dataset di training e quindi meno in grado di generalizzare o di gestire variazioni non presenti nel training set. Un modello più piccolo, focalizzato su un ambito ristretto, può ridurre questo rischio.

- Precisione nel Contesto Specifico: Un modello fine-tuned su un dataset specializzato può diventare molto preciso nel contesto per cui è stato addestrato. Se il dataset è rappresentativo dell’uso previsto del modello, quest’ultimo può fornire risultati di alta qualità per quella specifica applicazione.

In conclusione, quando l’applicazione riguarda argomenti molto specifici e verticali, un LM di dimensioni minori, se adeguatamente fine-tuned, può offrire prestazioni elevate, essere più gestibile in termini di risorse e fornire risposte molto precise e pertinenti all’ambito di applicazione. Tuttavia, è sempre importante considerare se l’ampiezza e la varietà delle informazioni coperte dal dataset di addestramento sono sufficienti per i compiti che il modello dovrebbe eseguire.

I campi di applicazione del RAG sono differenti, e l’utilizzo del RAG (Retrieval Augmented Generation) si rileva particolarmente vantaggioso in sistemi di assistenza clienti progettati per fornire informazioni aggiornate e dettagliate su una vasta gamma di argomenti. Per esempio, un sistema di supporto clienti per un’azienda che opera in un settore in rapida evoluzione, come la tecnologia o le finanze.

Ci sono scenari in cui gli utenti potrebbero porre domande molto specifiche e diversificate, che richiedono risposte basate su informazioni recenti e in continuo cambiamento. Ecco alcuni aspetti che rendono il RAG indispensabile in questo contesto:

- Accesso a Informazioni Aggiornate: Il settore della tecnologia e delle finanze è soggetto a cambiamenti frequenti, come nuove scoperte, aggiornamenti di prodotti, variazioni dei mercati e cambiamenti normativi. Un sistema RAG può cercare e recuperare informazioni da fonti esterne aggiornate per fornire risposte che riflettano le ultime novità e i dati più recenti.

- Ampia Gamma di Domande: In un settore ampio e complesso, gli utenti possono avere domande che vanno da richieste tecniche molto specifiche a richieste di consigli generali. Il RAG, con la sua capacità di attingere a una vasta gamma di fonti, può gestire questa diversità in modo più efficace rispetto a un modello basato solo sul fine tuning.

- Personalizzazione delle Risposte: Il RAG può fornire risposte più personalizzate e pertinenti a situazioni specifiche dell’utente, combinando la conoscenza generale del modello con informazioni dettagliate recuperate in tempo reale.

- Riduzione della Necessità di Aggiornamenti Frequenti del Modello: Invece di addestrare regolarmente il modello AI su nuovi dati per mantenerlo aggiornato, il RAG può attingere automaticamente alle ultime informazioni disponibili online, riducendo la necessità di addestramenti frequenti.

- Gestione di Domande Non Prevedibili: In un campo in rapida evoluzione, spesso emergono nuove questioni e argomenti che non erano stati precedentemente considerati. Il RAG è in grado di gestire queste domande impreviste in modo più efficace, grazie alla sua capacità di ricerca di informazioni in tempo reale.

In sintesi, in un contesto dove è cruciale fornire risposte attuali, dettagliate e personalizzate su un’ampia varietà di argomenti in continuo cambiamento, il RAG diventa uno strumento indispensabile. Questo approccio consente di superare i limiti dei modelli di AI basati esclusivamente su dati di addestramento, fornendo risposte più precise e aggiornate.

Quale modello è più adatto alle imprese

In contesti aziendali dove gli obiettivi, il dataset e il ruolo dell’intelligenza artificiale sono ben definiti, il fine tuning di un Language Model (LM) di dimensioni ridotte è spesso la scelta migliore. Ecco alcuni motivi per cui questa opzione è generalmente preferibile in tali scenari:

- Allineamento con Obiettivi Specifici: Il fine tuning consente di adattare il modello alle esigenze e agli obiettivi specifici dell’azienda. Questo significa che il modello può essere ottimizzato per compiti ben definiti, come assistenza clienti, analisi di dati specifici dell’azienda, o automazione di determinate attività.

- Efficienza e Gestibilità: I modelli di dimensioni ridotte sono più efficienti in termini di risorse computazionali e più facili da gestire. Questo li rende ideali per le aziende che desiderano integrare l’AI nei loro sistemi senza un impatto significativo sulle infrastrutture IT esistenti.

- Velocità e Risposta: Un modello più piccolo e fine-tuned è in grado di fornire risposte rapide, un aspetto cruciale in molte applicazioni aziendali dove la velocità di risposta è fondamentale.

- Controllo sui Dati e sulla Privacy: Utilizzando un fine tuning su dati specifici dell’azienda, si ha un maggiore controllo sulla privacy e sulla sicurezza dei dati. Questo è particolarmente importante in contesti aziendali dove la gestione delle informazioni sensibili è una priorità.

- Minore Necessità di Addestramento Continuo: Poiché il modello è addestrato su un set di dati ben definito e specifico per l’azienda, potrebbe non essere necessario aggiornarlo frequentemente, a meno che non si verifichino cambiamenti significativi nei dati o negli obiettivi aziendali.

- Coerenza e Qualità delle Risposte: In un ambiente aziendale, è importante che le risposte fornite dalla AI siano coerenti e di alta qualità. Il fine tuning su un dataset specifico aiuta a garantire che le risposte siano rilevanti e affidabili.

In conclusione, per le aziende con esigenze ben definite e dataset specifici, un LM fine-tuned di dimensioni ridotte offre un buon equilibrio tra personalizzazione, efficienza, gestibilità e controllo, rendendolo un’opzione adatta per molti scenari aziendali.